In de snel evoluerende wereld van Data and Analytics, het vermogen om naadloos te communiceren met complexe systemen is van het grootste belang. Als toonaangevende leverancier van professionele services en oplossingen in het veld lopen we voorop bij het benutten van de kracht van Large Language Models (LLM’s) om deze interacties te vereenvoudigen. Onze gemeenschappen, en vooral de NLP-gemeenschap, zijn verheugd om onze expertise te delen via een reeks instructievideo’s die zijn bedoeld om het potentieel van LLM’s en generatieve AI te demonstreren.

Onze eerste tutorial in deze serie richt zich op de integratie van LLM’s met de Databricks API, een krachtige tool voor data-analyse. Dit artikel geeft een gedetailleerd overzicht van de zelfstudie en laat zien hoe we LLM’s kunnen gebruiken om een taalinterface te bouwen, taakvoorwaarden te wijzigen, machtigingen te beheren en zelfs een model in productie te brengen. Of je nu een doorgewinterde datawetenschapper bent of een nieuwsgierige beginner, deze gids biedt waardevolle inzichten in de mogelijkheden van LLM’s en hun rol bij het vormgeven van de toekomst van data en analyse.

Inleiding tot taalinterface met Databricks API

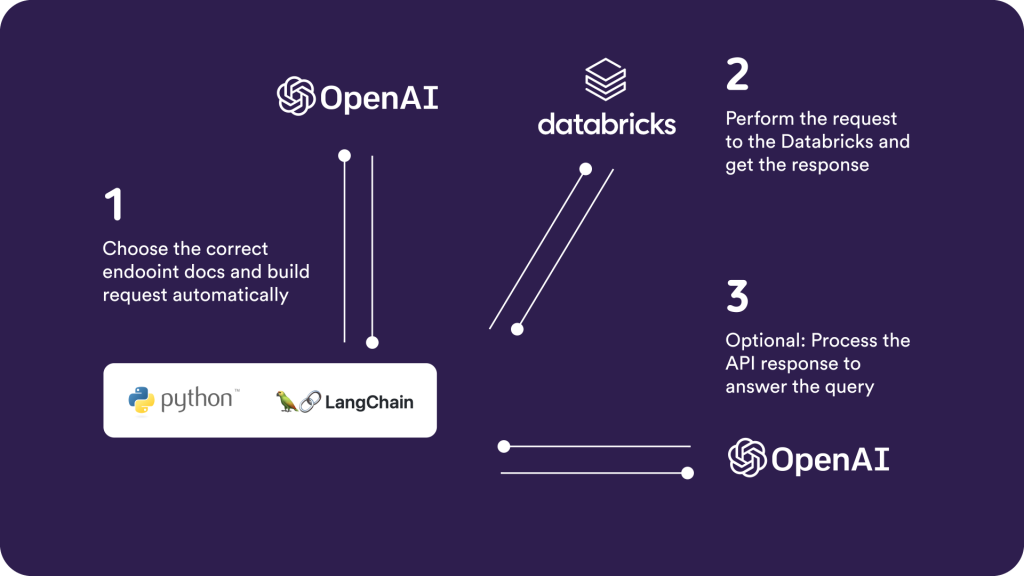

In deze eerste aflevering duiken we in de fascinerende wereld van LLM’s en hun toepassing bij het bouwen van een taalinterface voor de Databricks API. Onze tutorial maakt gebruik van een op Python gebaseerde Command Line Interface (CLI) en de veelgebruikte LangChain Library om dit te demonstreren.

Het proces omvat het invoeren van een zoekopdracht in het Engels (Ja – in natuurlijke taal!), die vervolgens door de LLM wordt geïnterpreteerd om de juiste eindpuntdocumentatie te selecteren. Deze informatie wordt gebruikt om de aanvraaglink te construeren. Dit verzoek wordt vervolgens uitgevoerd en het antwoord van de Databricks API wordt ontvangen en verwerkt om de eerste query te beantwoorden.

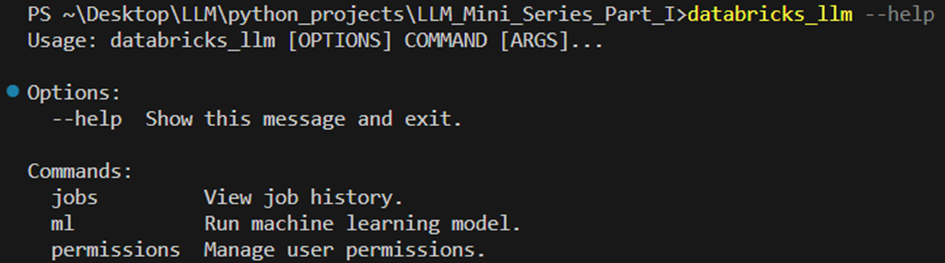

Het gebruik is analoog aan elke andere CLI. Hier is een overzicht van de beschikbare commando’s.

Elk commando biedt subcommando’s, zoals het volgende “get-model-info” voor het ontvangen van informatie over een bepaald model (here: ‘sentiment_classifier’) in het modelregister.

Access to the GitHub Repository: https://github.com/PositiveThinkingComp/LLM_Mini_Series_Part_I

In de huidige tutorial praten we met de Databricks API om:

- Luisteren en jobs wijzigen

- Machtigingen wijzigen en e-learning functionaliteiten

- Een model in productie zetten

Onderzoek naar andere mogelijke use-cases van LLM’s in API-integraties

De mogelijkheden van LLM’s in API-integraties gaan veel verder dan wat we in deze zelfstudie hebben gedemonstreerd. De mogelijkheid om te communiceren met API’s met behulp van natuurlijke taal opent een wereld van mogelijkheden voor verschillende industrieën en toepassingen. Hier zijn een paar mogelijke use-cases:

Customer Support Automation

LLM’s kunnen worden gebruikt om klantondersteuningssystemen te automatiseren. Door LLM’s te integreren met een API, kunnen bedrijven een systeem creëren waarin klanten vragen kunnen stellen in natuurlijke taal. De LLM kan de query interpreteren, communiceren met de benodigde API om gegevens op te halen of te manipuleren en op een gebruiksvriendelijke manier een antwoord geven. Dit kan de efficiëntie en effectiviteit van klantenondersteuning aanzienlijk verbeteren, wachttijden verkorten en de klanttevredenheid verbeteren.

Data Analyse and Reporting

In het data-analysedomein kunnen LLM’s het proces van het genereren van rapporten en inzichten vereenvoudigen. Gebruikers kunnen het systeem vragen stellen in natuurlijke taal, zoals “Wat waren de verkoopcijfers van het afgelopen kwartaal?” of “Hoeveel nieuwe gebruikers hebben zich vorige maand aangemeld?”. De LLM kan deze vragen begrijpen, communiceren met de relevante API om de gegevens op te halen en deze in een begrijpelijk formaat presenteren. Dit kan data-analyse toegankelijker maken voor niet-technische gebruikers en datagestuurde besluitvorming vergemakkelijken.

Healthcare Applications

In healthcare, LLMs can be used to create more intuitive interfaces for Electronic Health Record (EHR) systems. Healthcare professionals could ask the system for patient information using natural language, and the LLM could retrieve the relevant data from the EHR. This could make it easier for healthcare professionals to access and update patient information, improving the efficiency of healthcare delivery.

Education Tools:

LLM’s kunnen ook worden gebruikt om meer interactieve en boeiende educatieve hulpmiddelen te creëren. Een LLM kan bijvoorbeeld worden geïntegreerd met een API die informatie geeft over historische gebeurtenissen. Studenten kunnen het systeem vragen stellen in natuurlijke taal en de LLM kan de relevante informatie ophalen, waardoor leren interactiever en boeiender wordt.

De integratie van LLM’s met API’s heeft het potentieel om de manier waarop we omgaan met systemen en gegevens ingrijpend te veranderen. Door meer natuurlijke en intuïtieve interacties mogelijk te maken, kunnen LLM’s complexe systemen toegankelijker maken, de efficiëntie verbeteren en de weg vrijmaken voor nieuwe innovatiemogelijkheden.

Kortom, de integratie van LLM’s met API’s is meer dan een technologische advertentie

Toegang tot de GitHub-repository: https://github.com/PositiveThinkingComp/LLM_Mini_Series_Part_I

Abonneer je op ons YouTube-kanaal: https://www.youtube.com/@Positive_Thinking_Company